Neural Network의 구조

Neural Network의 가장 작은 단위는 neuron이다.

여러 개의 뉴런이 하나의 layer를 이룬다. layer의 수는 1개일 수도 있고 여러 개일 수도 있다.

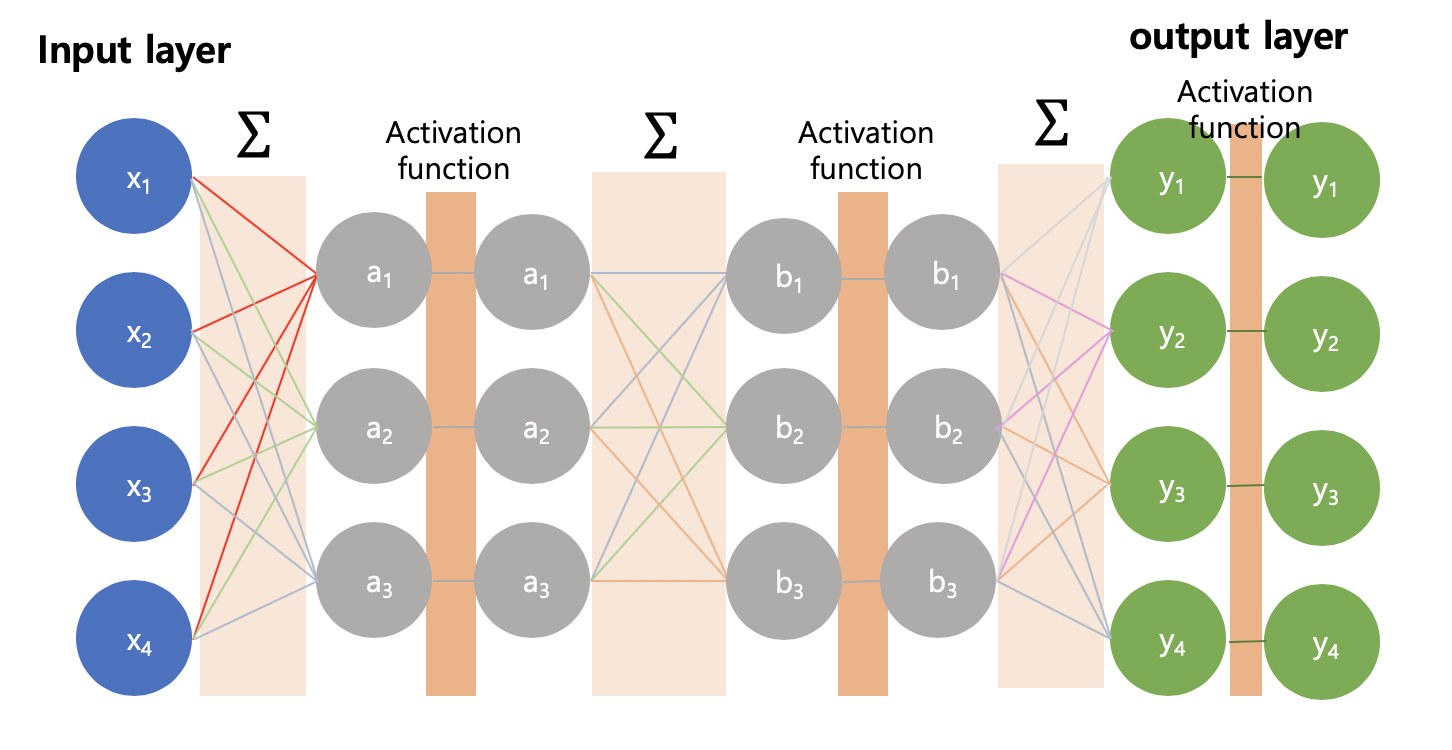

neural network의 기본 구조는 아래 사진과 같다. 아래는 layer가 2개인 경우이다.

input layer(파란 부분)

학습시킬 데이터를 encoding해서 넣는 layer

(x1, x2, x3, x4)가 input data이다.

hidden layer(회색 부분)

일반적으로 layer의 수는 input layer와 output layer를 제외한 hidden layer의 수를 말한다.

output layer(초록 부분)

최종 산출물 layer.

(y1, y2, y3, y4)가 (x1, x2, x3, x4)에 대한 output(결과값)이다.

weight(가중치)

layer 사이에서 선으로 연결한 부분이 weight이다.

각 layer의 neuron은 전 layer의 neuron과 연결되어있다.

neuron에서의 연산

빨간색 선만 확대해서 보면 다음과 같다.

1) ∑ = w · x + b 를 계산한다.

w = weight vector, x = vector x, b = bias 이다.

w 와 x의 내적을 하고, bias를 더한다. linear transformation이다.

2) activation function에 ∑를 넣는다.

이것을 모든 neuron과 layer에 대해 반복한다.

따라서 실제로는 다음과 같이 연산이 이루어진다.

Fully Connected Network

한 뉴런이 그 전 layer의 모든 neuron과 연결되어있기 때문에 Fully Connected Network라고도 한다.

activation function(활성함수)

threshold(임계값/기준값)을 기준으로, 값을 정해주는 함수

대표적인 예시로는 step function과 sigmoid가 있다.

step function

sigmoid function

'Machine Learning > 이론 정리' 카테고리의 다른 글

| 3-4. Neural Network 연산 - Backpropagation(역전파) (0) | 2020.02.14 |

|---|---|

| 3-3. Neural Network 연산 - feedforward, loss function (0) | 2020.02.14 |

| 3-1. neural network(인공 신경망)의 기본 개념 (0) | 2020.02.11 |

| 2. 인공지능(artificial intelligence) vs. 머신러닝(machine learning) vs vs. 인공 신경망(neural network) 비교 (0) | 2020.02.11 |

| 1-2. supervised learning / unsupervised learning / reinforcement learning (0) | 2020.02.09 |